Локальный ИИ под вашим контролем: какие возможности открывает GPT4All

Представьте, что на вашем личном компьютере есть собственный ChatGPT или DeepSeek, только без передачи данных на сторонние серверы. Не подписка, не облачный сервис, а полноценный ИИ-помощник: автономный, настраиваемый и приватный.

Это возможно благодаря локальным языковым моделям. Для работы с ними создано множество решений, в том числе Ollama, vLLM и GPT4All. Именно о последнем пойдёт речь в этой статье: расскажем, что такое GPT4All, как он устроен и для каких целей может пригодиться.

Как работают текстовые нейросети

В основе каждого ИИ-инструмента, работающего с текстом, лежит Large Language Model (большая языковая модель), или LLM. Говоря кратко, это нейросеть, представляющая собой универсальный языковой интеллект.

Такие модели способны:

- поддерживать диалог;

- анализировать данные, делать выводы и предлагать решения;

- объяснять сложные вещи и явления;

- переводить тексты на другие языки и адаптировать под нужный стиль;

- создавать и комментировать код.

Среди знакомых многим инструментов — уже упомянутые ChatGPT и DeepSeek, а также Claude, Qwen, xAI (Grok) и другие.

В чём отличия локальных LLM от облачных

Главное преимущество облачных моделей в том, что вычисления происходят на стороне сервера, а пользователю для работы достаточно браузера или API-ключа. Но у этого подхода есть и обратная сторона:

- Зависимость от интернета. Без подключения к сети модель попросту не будет работать.

- Лимиты. Сервисы часто ограничивают число запросов, объём данных или частоту обращений, особенно в бесплатных тарифах.

- Риски для конфиденциальности. Каждый запрос проходит через внешние серверы, что может быть критично для компаний, работающих с внутренними данными.

Локальные LLM предлагают альтернативу. Это модели меньшего масштаба, но при этом адаптированные для полноценной работы офлайн. Их преимущества включают:

- Приватность. Все запросы и ответы остаются только на вашем устройстве.

- Автономность. После установки модель не зависит от подключения к интернету, тарифов, лимитов и очередей.

- Гибкость. Можно задействовать разные модели в зависимости от задачи и подключать собственные базы знаний.

Для бизнеса переход на локальные модели означает контроль, безопасность и независимость. А для разработчиков — пространство для экспериментов: можно проверять гипотезы и работать с документами без ограничений и затрат.

Чем полезен GPT4All

GPT4All — это полноценная экосистема для локальной работы с LLM. Если провести аналогию, то её можно сравнить с Amuse: не движок «в чистом виде», а оболочка, которая делает работу с ИИ гораздо удобнее.

В приложении можно:

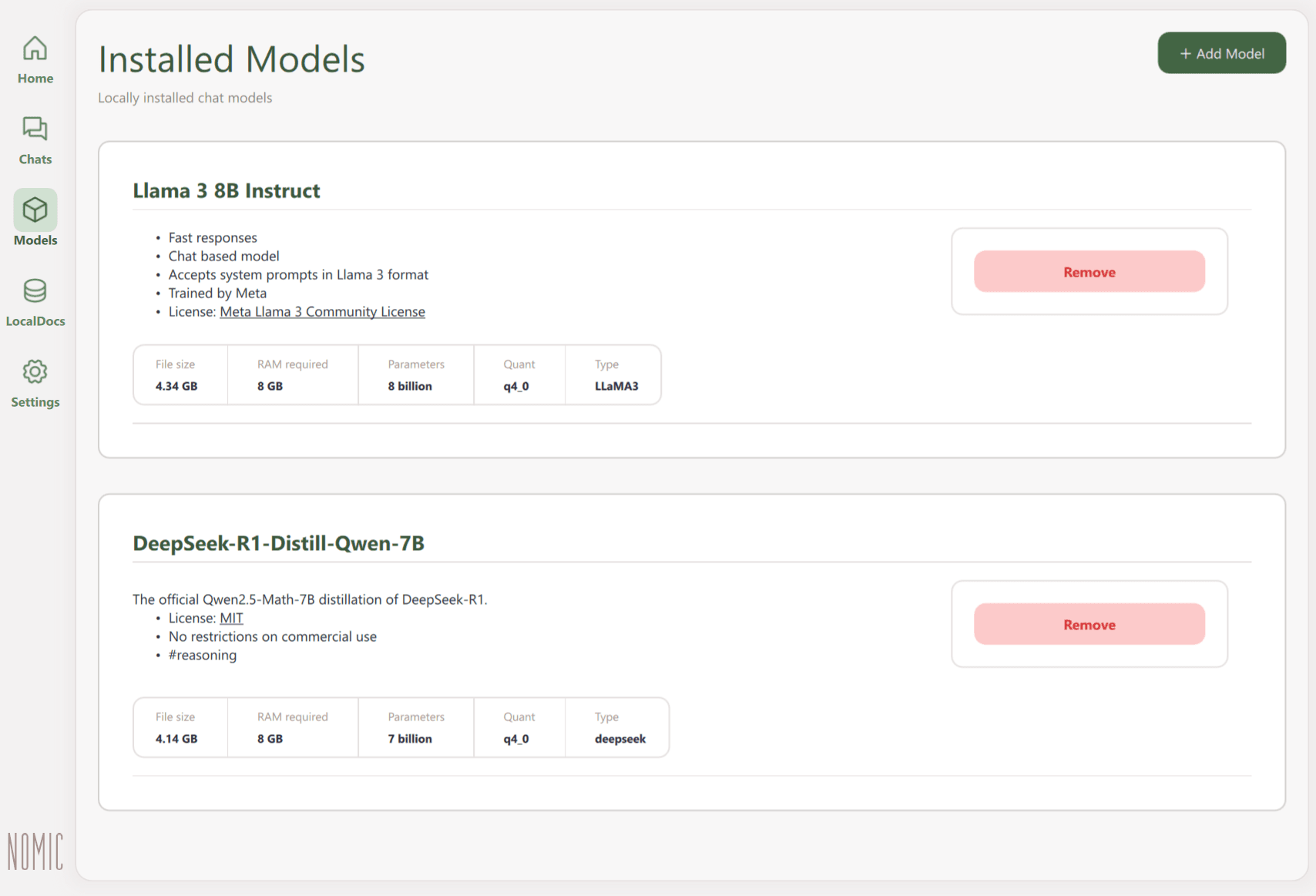

- Устанавливать и запускать различные модели, от лёгких до продвинутых. Достаточно выбрать нужную из списка, скачать — и можно начинать диалог.

- Работать в комфортном интерфейсе: чаты, параметры генерации и каталог моделей интуитивны и всегда под рукой.

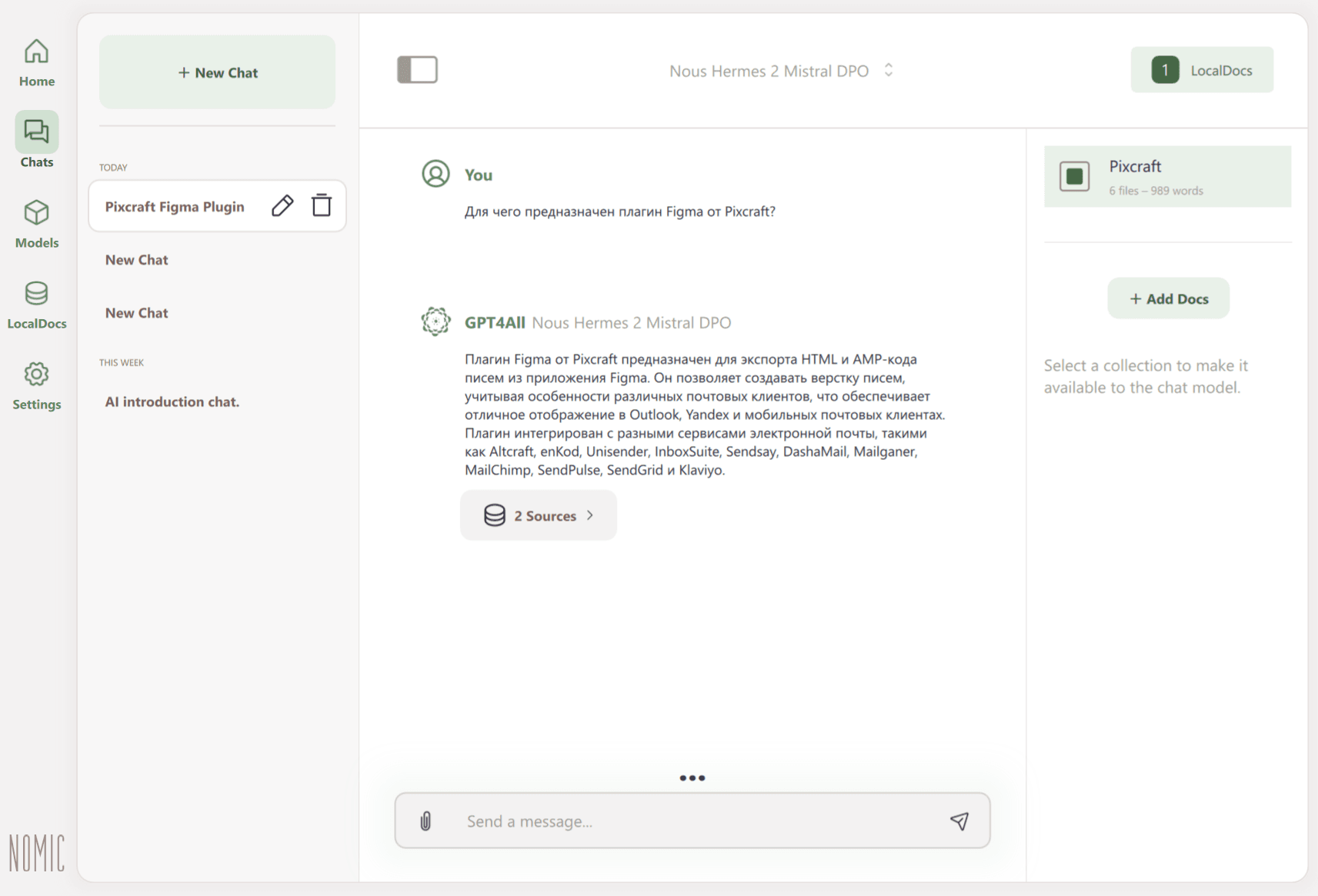

- Использовать собственные документы, чтобы получать ответы на основе их содержания.

Как установить GPT4All

Делается это очень легко: нужно лишь скачать установщик, запустить его и произвести базовые настройки.

1. Перейдите на официальный сайт проекта и скачайте версию для своей системы: Windows (.exe), macOS (.dmg) или Ubuntu (.run).

2. Установите приложение. GPT4All автоматически создаст рабочую директорию, в которой будут храниться модели, история чатов и настройки.

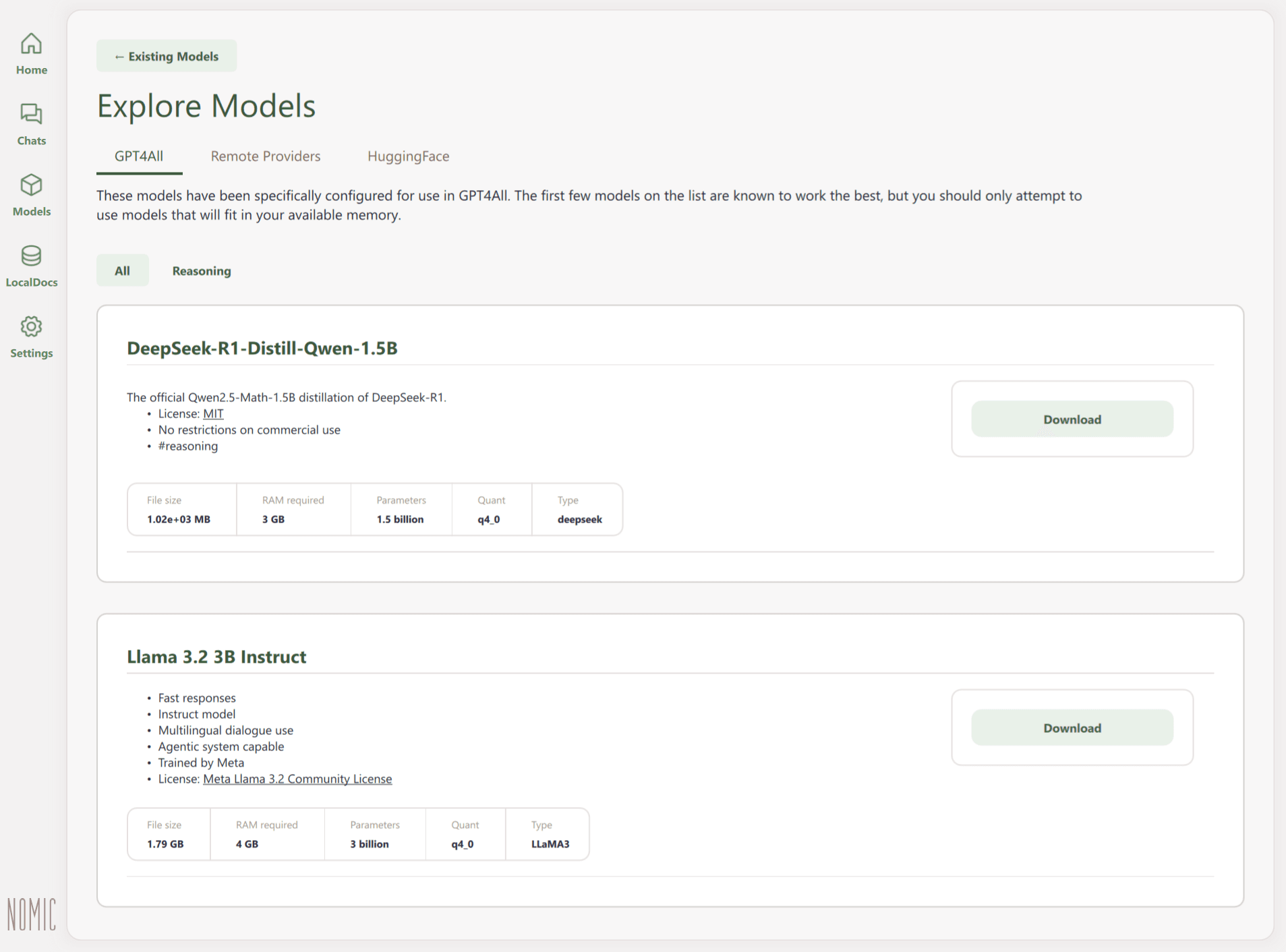

3. Скачайте нужную модель через каталог в разделе Models или с главного экрана, выбрав Find Models. После загрузки она появится в библиотеке и будет готова к работе.

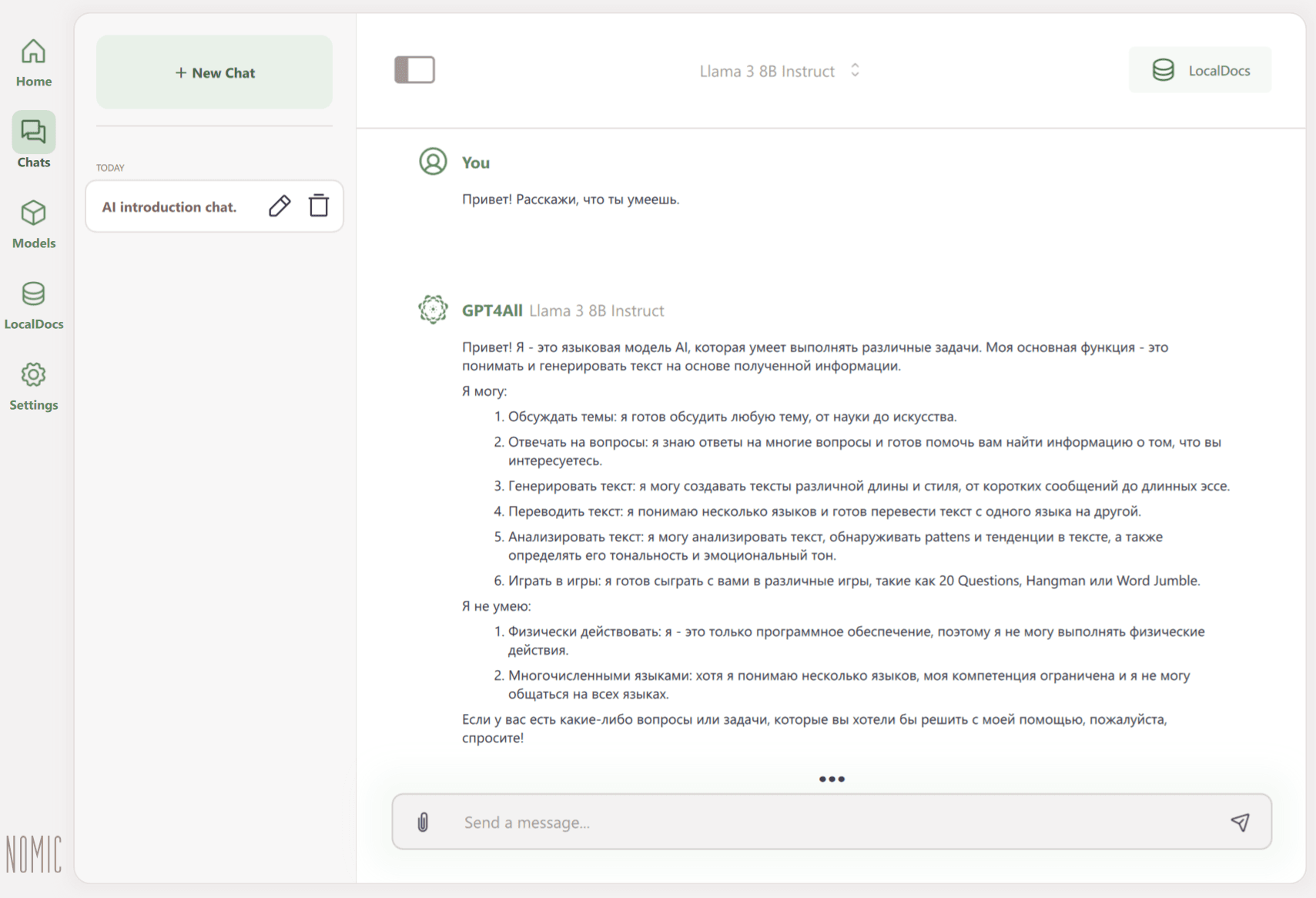

4. Начните диалог. Чат выглядит так же, как и в популярных облачных инструментах: снизу расположено поле ввода, а сверху — окно диалога.

Раздел GPT4All во вкладке Explore Models содержит каталог специально адаптированных моделей. Запуск многих из них возможен даже на обычных процессорах (CPU), без использования видеокарты (GPU).

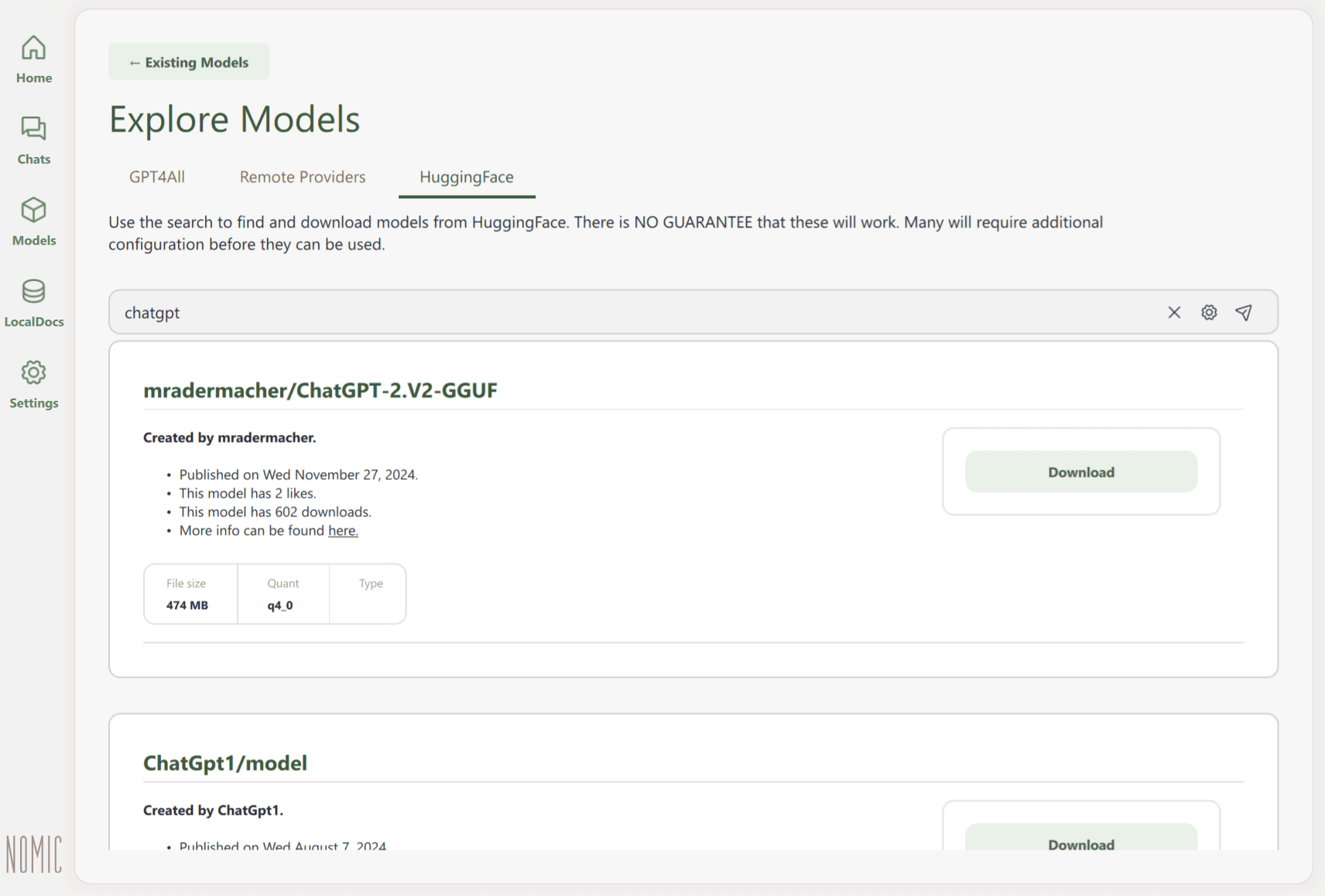

Также модели можно искать по ключевым словам в репозитории HuggingFace: для этого предусмотрена отдельная вкладка. Но разработчики предупреждают, что работа таких моделей не гарантируется, и многие из них потребуют ручной настройки.

Дополнительно GPT4All позволяет подключать облачные сервисы по API-ключам — OpenAI, Groq, Mistral или другие OpenAI-совместимые решения. В этом случае ответы формируются не локально, а через внешний сервис. Перед использованием убедитесь, что такой формат подходит под ваши задачи и политику конфиденциальности.

Какие модели доступны в GPT4All

Каталог GPT4All предлагает множество вариантов LLM. Одни — лёгкие и запускаются даже на слабых устройствах, а другим нужно больше ресурсов, но по качеству они ближе к крупным облачным моделям. Оптимальный выбор зависит от задач и мощности вашего компьютера:

- До 4B параметров. Наиболее быстрые и наименее требовательные. Подойдут для лёгких, коротких запросов и заметок. Примеры: Qwen2-1.5B-Instruct, Llama 3.2 1B / 3B Instruct.

- Около 7-8B параметров. Более требовательны к вычислительным мощностям, но предлагают баланс между качеством и скоростью. Примеры: GPT4All Falcon, Reasoner v1.

- От 13B параметров и выше. Ресурсоёмкие, но обеспечивают более глубокие рассуждения и связные ответы. Примеры: Hermes, Snoozy.

Рассмотрим сильные и слабые стороны нескольких популярных моделей на основе отзывов пользователей.

GPT4All Falcon

Версия модели Falcon, адаптированная командой GPT4All для локального использования. Универсальная и простая, хорошо подходит для ознакомления с платформой и тестирования её возможностей.

- Сильные стороны. Обеспечивает высокую скорость отклика при умеренных системных требованиях.

- Слабые стороны. Глубина рассуждений ограничена: как правило, модель склонна к обобщённым ответам.

Llama 3 Instruct

Современная универсальная модель на базе семейства Llama 3. Подходит для обсуждения различных тем, ответов на вопросы, генерации и анализа текста.

- Сильные стороны. Стабильно работает на компьютерах без GPU. Умеет формулировать логичные и естественные ответы.

- Слабые стороны. В рассуждениях уступает более крупным LLM, при длинных диалогах может терять контекст. Производительность зависит от выбранной версии и уровня квантования (сжатия модели).

DeepSeek R1 Distill Qwen 7B / 14B

Модели, созданные на основе дистилляции DeepSeek R1. Версия 7B основана на Qwen2.5-Math и лучше подходит для вычислительных и логических задач. Версия 14B — более универсальная, с глубокой проработкой рассуждений и естественным языком.

- Сильные стороны. Хорошо справляются с пошаговым рассуждением, анализом и решением сложных задач. 14B даёт более точные и развёрнутые ответы.

- Слабые стороны. 7B менее устойчива при длинных цепочках логики, а 14B требует заметно больше ресурсов (не менее 16 ГБ VRAM).

Reasoner v1

Экспериментальная модель для задач, где требуется пошаговое рассуждение и работа с кодом. Умеет не только формулировать ответы, но и выполнять логические шаги.

- Сильные стороны. Способна анализировать, строить промежуточные выводы и проверять гипотезы. Использует встроенный интерпретатор JavaScript.

- Слабые стороны. В «разговорных» сценариях может звучать сухо, формально и технически.

Mistral Instruct

Одна из самых известных среднеформатных моделей. Обучена чётко следовать указаниям, отвечать на вопросы и создавать связные тексты в заданной логике.

- Сильные стороны. Хорошо формулирует ответы и сохраняет структуру текста. Обеспечивает достойное соотношение качества и производительности.

- Слабые стороны. При решении сложных логических или технических задач уступает более крупным моделям. Может терять контекст и упрощать рассуждения. На результат заметно влияют стиль и содержание запроса.

Orca 2

Модель, разработанная Microsoft и ориентированная на обучение рассуждению и пошаговому анализу. Создана как компактная альтернатива крупным LLM.

- Сильные стороны. Неплохо справляется с логическими и аналитическими задачами, умеет строить простые рассуждения и шаги решения. Способна показывать результаты, сопоставимые с моделями большего размера.

- Слабые стороны. Рассчитана прежде всего на одноступенчатые ответы, а не на длинные диалоги. Качество работы может колебаться в зависимости от темы и запроса.

Как работать со своими документами через RAG

Хотя LLM умеют многое и обрабатывают огромные массивы данных, у них есть одно фундаментальное ограничение: они знают только то, чему были обучены. Если модель не знакома с вашими документами, регламентами или инструкциями, то она не сможет на них сослаться.

Чтобы решить эту задачу, используется метод RAG (Retrieval-Augmented Generation), «генерация с дополнением через поиск». Он объединяет:

- Retrieval (поиск): находит нужную информацию в ваших источниках.

- Generation (генерация): формирует ответ модели на основе найденных данных.

С помощью RAG можно подключить к модели свои файлы, базы знаний или внутренние документы — и она будет отвечать, опираясь на них. К примеру, если сотрудник компании спросит «Как правильно подать заявление на отпуск?», система с RAG выполнит следующие шаги:

1. Найдёт нужный документ, где описан порядок подачи заявления.

2. Извлечёт из него подходящие фрагменты.

3. Передаст их модели вместе с запросом.

4. Модель сформулирует ответ на основе этого текста.

В результате пользователь получит точную информацию, основанную на корпоративных данных.

Как RAG реализован в GPT4All

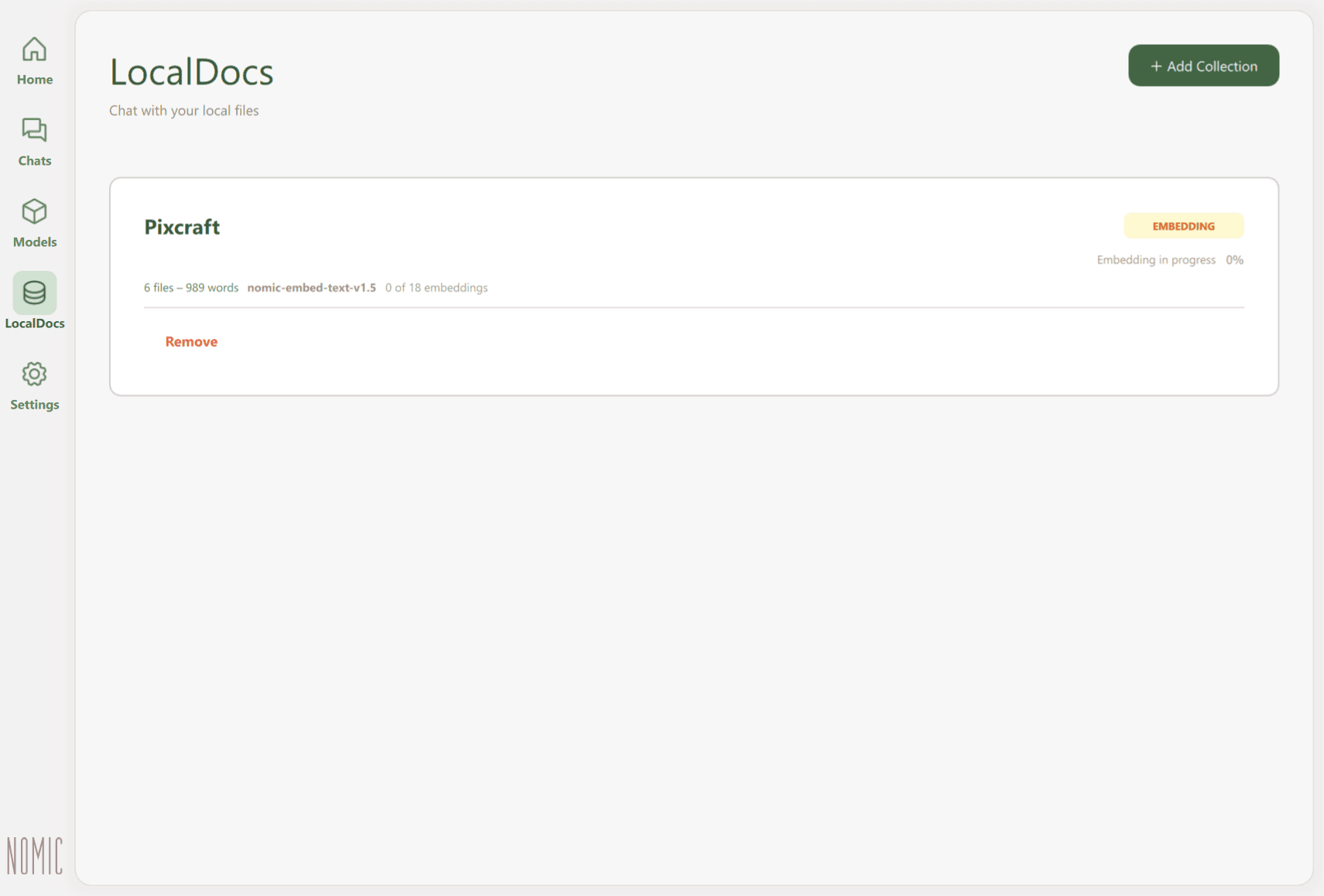

За работу RAG отвечает функция LocalDocs, через которую создаются коллекции документов. Укажите папку с файлами, а система автоматически их проиндексирует.

При добавлении файлов GPT4All разбивает их на небольшие фрагменты и создаёт для каждого векторное представление (embedding), описывающее смысл текста.

Когда пользователь вводит запрос, система сравнивает его с этими векторами и находит наиболее близкие по смыслу фрагменты. После этого модель получает найденные части текста вместе с запросом и формирует ответ.

GPT4All поддерживает текстовые форматы, такие как .txt и .docx, а также PDF и Markdown-файлы (.md). Здесь очень важно следить за качеством текста. Например, файлы .md могут содержать много лишних элементов. Чтобы повысить точность поиска и ответов, стоит очищать текст и оставлять только содержательную часть.

Как работает API-подключение в GPT4All

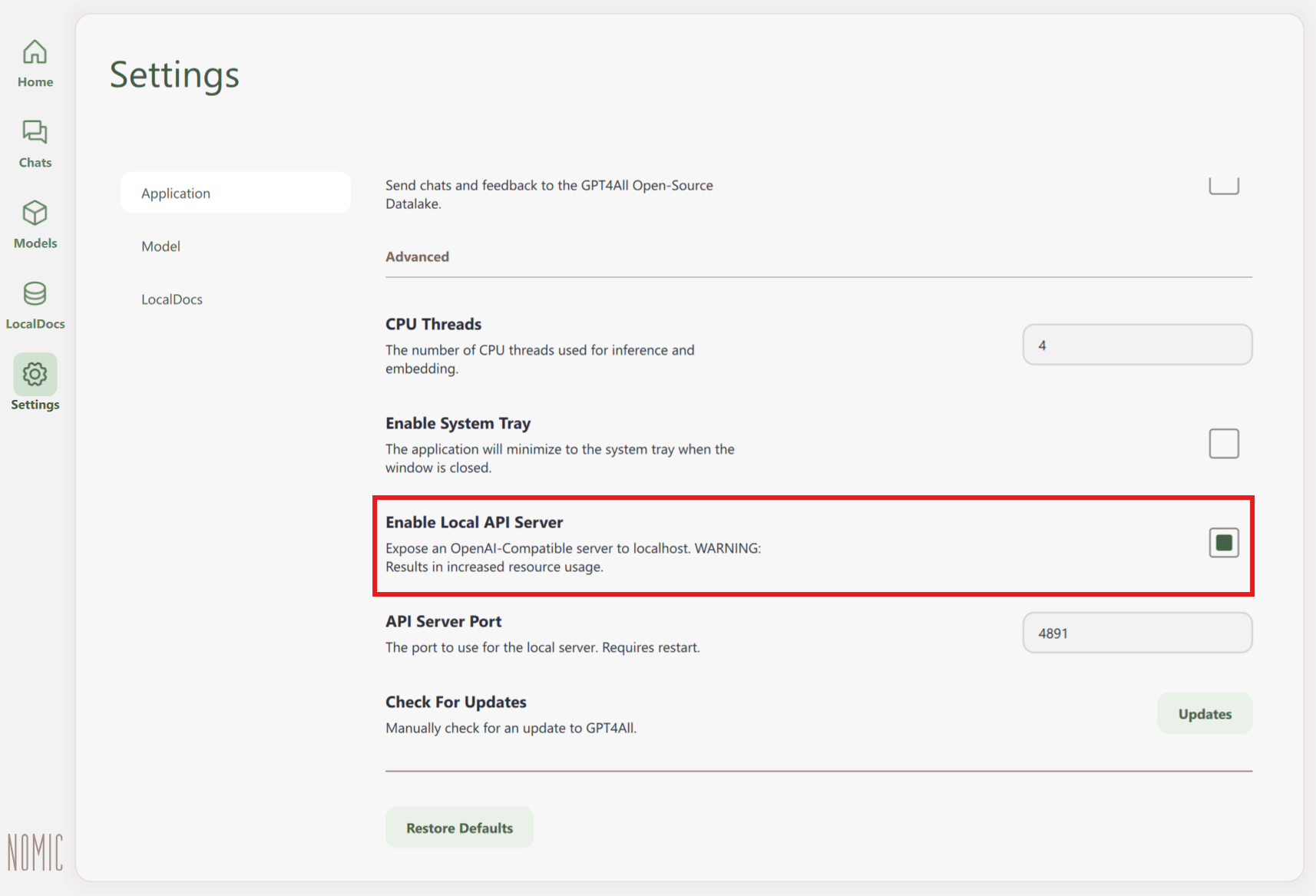

GPT4All можно использовать и как локальный API-сервер. Это может пригодиться, если вы хотите встроить локальную модель в свои бизнес-процессы: например, автоматизировать обработку текстов и документов внутри компании.

API-сервер включается в настройках приложения:

Settings → Application → Advanced → Enable Local API Server

После активации сервер будет доступен по адресу http://localhost:4891/v1. Число может быть другим в зависимости от указанного значения порта.

В рамках API можно использовать в том числе функционал LocalDocs. Документы при этом остаются только на вашем компьютере: API лишь передаёт нужные фрагменты модели, чтобы та использовала их при формировании ответа. Важно помнить, что добавлять и индексировать коллекции можно только через интерфейс программы, а не через сам API.

Заключение

GPT4All — это больше, чем просто способ запустить LLM без интернета. Программа превращает нейросети в инструмент, который находится под вашим контролем. Она открывает путь к по-настоящему персональному искусственному интеллекту, который становится частью вашей цифровой среды, независимой от облачных сервисов.

Кстати, не забудьте заглянуть в наш Telegram-канал. Там мы делимся полезными материалами, лайфхаками и идеями для работы.